Meta ha presentado un nuevo conjunto de herramientas para facilitar la investigación en robótica, entre las que destaca el simulador de robots y avatares humanoides Habitat 3.0, que permite entrenar a robots para ayudar en tareas cotidianas con humanos.

La compañía estadounidense ha compartido su objetivo de mejorar la tecnología detrás de los robots «socialmente inteligentes», de manera que puedan ayudar con las tareas cotidianas, además de adaptarse a las preferencias de sus «socios humanos».

En este sentido, Meta ha presentado las últimas incorporaciones desarrolladas por su grupo de investigadores FAIR, que se basan en un nuevo conjunto de herramientas diseñadas para facilitar la investigación en robótica utilizando simuladores, conjuntos de datos y una plataforma de ‘hardware’ y ‘softwre’ de asistente de robot doméstico.

Tal y como ha explicado en un comunicado en su blog, estas herramientas están ideadas para trabajar en el desarrollo de «agentes de IA con personificación social» que puedan cooperar y ayudar a los humanos en su vida diaria.

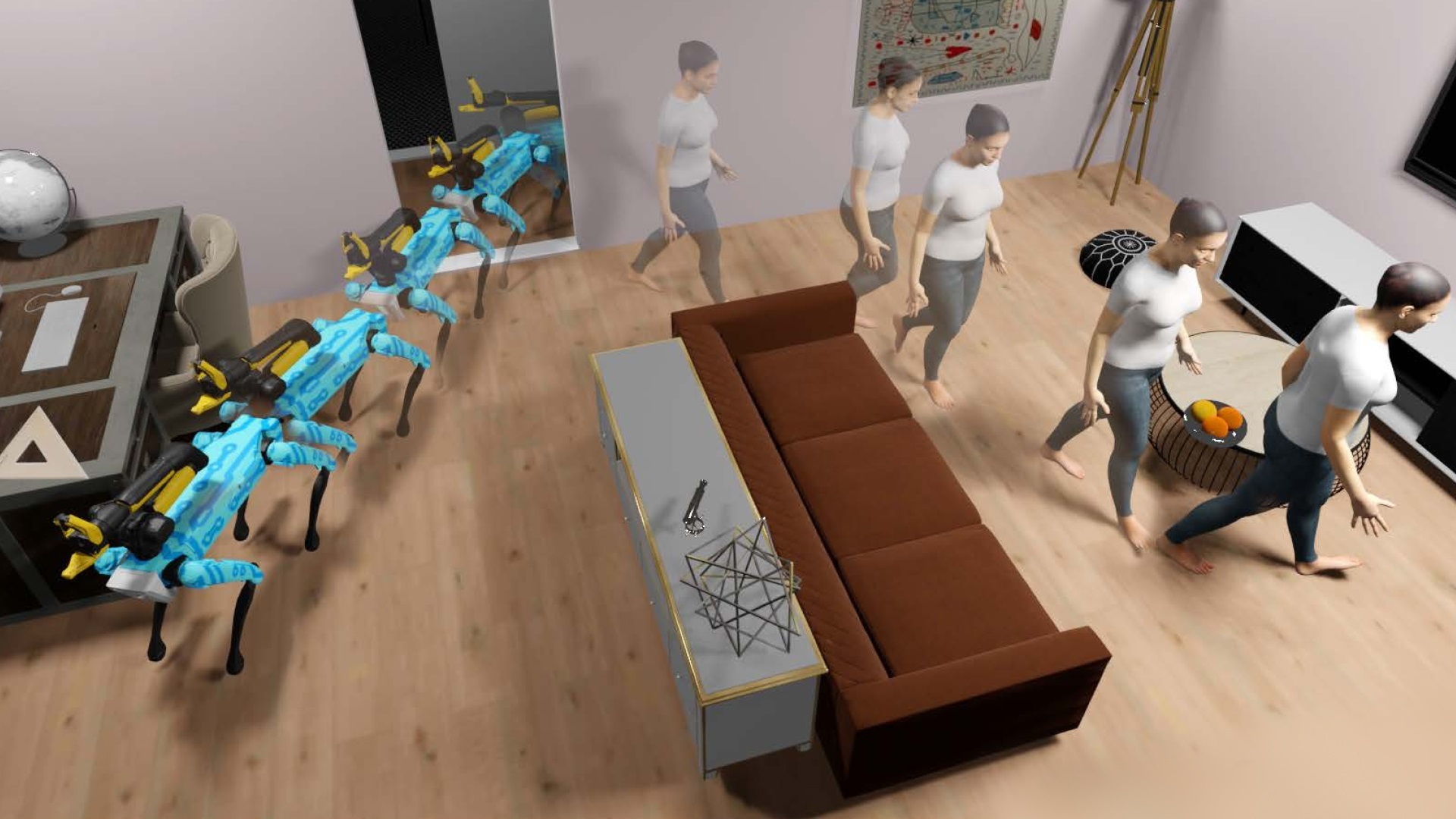

Así, una de las herramientas más destacadas ha sido el simulador de robots y avatares humanoides Habitat 3.0, que permite la colaboración entre humanos y robots en «entornos hogareños». En concreto, se trata del primer simulador que posibilita el entrenamiento a gran escala sobre la interacción persona-robot en entornos de interiores realistas.

Este simulador es un método utilizado para avanzar en las capacidades robóticas con el que, desde el equipo de Meta, desarrollan nuevos algoritmos y modelos y los prueban en el simulador. Tras ello, pasan a transferir estos algoritmos a los robots físicos.

Meta comenzó a trabajar en este simulador en el año 2019 con Habitat 1.0, con lo que consiguió llevar a cabo cuestiones entrenar a robots en la navegación a gran velocidad por imágenes escaneadas en 3D de casas del mundo real.

Asimismo, en el año 2021 la compañía comenzó a desarrollar Habitat 2.0, con el que introdujo entrenamientos para actuar en entornos interactivos, con acciones como coger objetos o abrir cajones. De esta forma, los robots llegan a aprender tareas como ordenar una sala de estar o preparar una receta en la cocina, según Meta.

Siguiendo esta línea, con Habitat 3.0 se basa en todos los avances anteriores incluyendo además la interacción con humanos. Para ello, el simulador admite robots y avatares humanoides para entrenar su colaboración en tareas cotidianas.

Los humanos son personalizables y tienen apariencia realista, con modos de andar y acciones naturales para modelar interacciones realistas. Incluso, estos avatares son controlables tanto mediante políticas aprendidas, como mediante humanos reales utilizando controles a través de teclado y ratón o un visor VR.

«Esta cohabitación de humanos y robots en el entorno de simulación nos permite por primera vez aprender políticas de IA robótica en presencia de avatares humanoides en entornos hogareños en tareas cotidianas y evaluarlas con humanos reales en el circuito», ha sentenciado Meta.

Esto se traduce en que no es necesario utilizar millones de iteraciones con los robots para aprender algo significativo, lo que suele llevar años realizando estos experimentos en el mundo físico y, con el simulador Habitat 3.0, se consigue en «unos pocos días».

Igualmente, esto permite no correr riesgos de que el robot dañe a las personas o al entorno durante el entrenamiento en el mundo físico, ya que las pruebas se realizan en un espacio seguro antes de pasar a la realidad. Por otra parte, se permite ensayar en múltiples espacios distintos que se pueden configurar rápidamente.

Además de todo ello, Meta ha detallado que estos avances se experimentan con usuarios reales utilizando el marco de evaluación humano simulado, que también se proporciona en el simulador Habitat 3.0.

CONJUNTO DE DATOS HSSD-200

En relación a Habitat 3.0, Meta también ha presentado su conjunto de datos de escenas sintéticas de hábitat HSSD-200, que se basan en datos de escenas 3D que se utilizan para entrenar a los robots en el simulador, ya que representan fielmente las escenas físicas.

En concreto, Meta ha especificado que esta base de datos contiene 211 escenas en 3D con 18.656 modelos de objetos del mundo real en 466 categorías semánticas. Es decir, dispone de datos que representan hogares reales. De hecho, también incluye datos como hogares llenos de objetos pequeños.

Asimismo, la compañía ha subrayado que esta base de datos se diferencia por ofrecer interiores 3D de alta calidad y «totalmente creados por humanos», lo que permite una simulación de alto rendimiento.

PLATAFORMA HOMEROBOT

Finalmente, Meta ha presentado su plataforma de ‘hardware’ y ‘software’ de asistente de robot doméstico HomeRobot, con la que el robot puede aprender y realizar tareas de vocabulario abierto tanto en entornos simulados como en el mundo físico.

Para ello, la plataforma se centra la manipulación móvil de vocabulario abierto (OVMM por sus siglas en inglés). Esto es, la capacidad de recoger cualquier objeto en cualquier entorno invisible y colocarlo en una ubicación específica, lo que requiere una percepción y comprensión alta del espacio.

Con HomeRobot, un robot sería capaz de coger una taza de un armario y colocarla en la mesilla de noche del piso de arriba aunque nunca antes hubiera visto la taza o el dormitorio, según ha ejemplificado Meta.

HomeRobot tiene, por un lado, un componente de simulación, que utiliza un amplio y diverso conjunto de objetos seleccionados en nuevos entornos domésticos de múltiples habitaciones de alta calidad. Por otra parte, dispone de un componente del mundo real, que proporciona ‘software’ para robots como Hello Robot Stretch, con el fin de fomentar la réplica de experimentos entre laboratorios.

TecnologíaHace 3 años

TecnologíaHace 3 años

TecnologíaHace 1 año

TecnologíaHace 1 año

EconomíaHace 3 años

EconomíaHace 3 años

EconomíaHace 2 años

EconomíaHace 2 años

EconomíaHace 2 años

EconomíaHace 2 años

EconomíaHace 2 años

EconomíaHace 2 años

EconomíaHace 2 años

EconomíaHace 2 años