Tecnología

Meta presenta el simulador Habitat 3.0, que permite entrenar a robots para ayudar en tareas cotidianas con humanos

Published

7 meses agoon

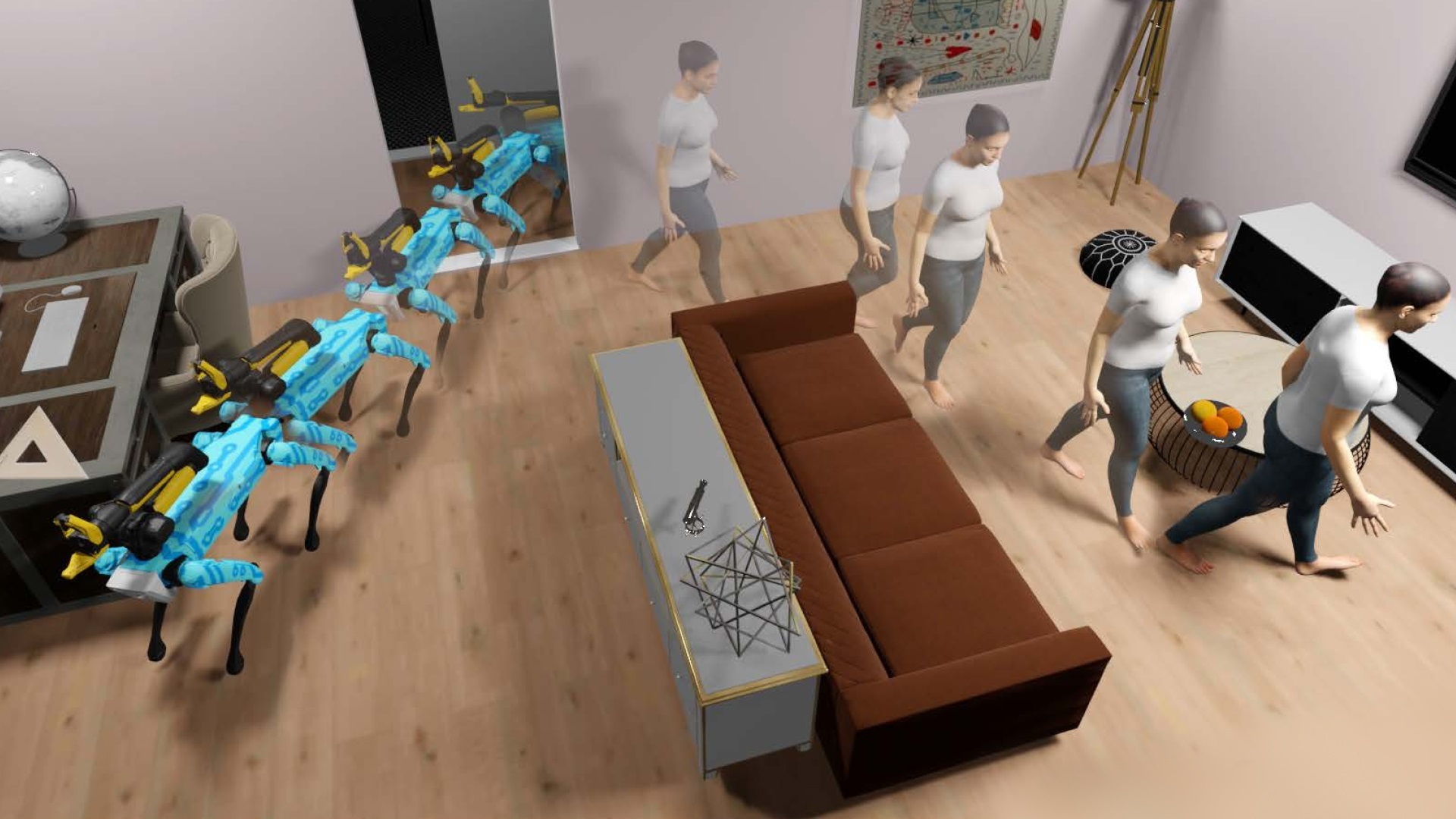

Meta ha presentado un nuevo conjunto de herramientas para facilitar la investigación en robótica, entre las que destaca el simulador de robots y avatares humanoides Habitat 3.0, que permite entrenar a robots para ayudar en tareas cotidianas con humanos.

La compañía estadounidense ha compartido su objetivo de mejorar la tecnología detrás de los robots “socialmente inteligentes”, de manera que puedan ayudar con las tareas cotidianas, además de adaptarse a las preferencias de sus “socios humanos”.

En este sentido, Meta ha presentado las últimas incorporaciones desarrolladas por su grupo de investigadores FAIR, que se basan en un nuevo conjunto de herramientas diseñadas para facilitar la investigación en robótica utilizando simuladores, conjuntos de datos y una plataforma de ‘hardware’ y ‘softwre’ de asistente de robot doméstico.

Tal y como ha explicado en un comunicado en su blog, estas herramientas están ideadas para trabajar en el desarrollo de “agentes de IA con personificación social” que puedan cooperar y ayudar a los humanos en su vida diaria.

Así, una de las herramientas más destacadas ha sido el simulador de robots y avatares humanoides Habitat 3.0, que permite la colaboración entre humanos y robots en “entornos hogareños”. En concreto, se trata del primer simulador que posibilita el entrenamiento a gran escala sobre la interacción persona-robot en entornos de interiores realistas.

Este simulador es un método utilizado para avanzar en las capacidades robóticas con el que, desde el equipo de Meta, desarrollan nuevos algoritmos y modelos y los prueban en el simulador. Tras ello, pasan a transferir estos algoritmos a los robots físicos.

Meta comenzó a trabajar en este simulador en el año 2019 con Habitat 1.0, con lo que consiguió llevar a cabo cuestiones entrenar a robots en la navegación a gran velocidad por imágenes escaneadas en 3D de casas del mundo real.

Asimismo, en el año 2021 la compañía comenzó a desarrollar Habitat 2.0, con el que introdujo entrenamientos para actuar en entornos interactivos, con acciones como coger objetos o abrir cajones. De esta forma, los robots llegan a aprender tareas como ordenar una sala de estar o preparar una receta en la cocina, según Meta.

Siguiendo esta línea, con Habitat 3.0 se basa en todos los avances anteriores incluyendo además la interacción con humanos. Para ello, el simulador admite robots y avatares humanoides para entrenar su colaboración en tareas cotidianas.

Los humanos son personalizables y tienen apariencia realista, con modos de andar y acciones naturales para modelar interacciones realistas. Incluso, estos avatares son controlables tanto mediante políticas aprendidas, como mediante humanos reales utilizando controles a través de teclado y ratón o un visor VR.

“Esta cohabitación de humanos y robots en el entorno de simulación nos permite por primera vez aprender políticas de IA robótica en presencia de avatares humanoides en entornos hogareños en tareas cotidianas y evaluarlas con humanos reales en el circuito”, ha sentenciado Meta.

Esto se traduce en que no es necesario utilizar millones de iteraciones con los robots para aprender algo significativo, lo que suele llevar años realizando estos experimentos en el mundo físico y, con el simulador Habitat 3.0, se consigue en “unos pocos días”.

Igualmente, esto permite no correr riesgos de que el robot dañe a las personas o al entorno durante el entrenamiento en el mundo físico, ya que las pruebas se realizan en un espacio seguro antes de pasar a la realidad. Por otra parte, se permite ensayar en múltiples espacios distintos que se pueden configurar rápidamente.

Además de todo ello, Meta ha detallado que estos avances se experimentan con usuarios reales utilizando el marco de evaluación humano simulado, que también se proporciona en el simulador Habitat 3.0.

CONJUNTO DE DATOS HSSD-200

En relación a Habitat 3.0, Meta también ha presentado su conjunto de datos de escenas sintéticas de hábitat HSSD-200, que se basan en datos de escenas 3D que se utilizan para entrenar a los robots en el simulador, ya que representan fielmente las escenas físicas.

En concreto, Meta ha especificado que esta base de datos contiene 211 escenas en 3D con 18.656 modelos de objetos del mundo real en 466 categorías semánticas. Es decir, dispone de datos que representan hogares reales. De hecho, también incluye datos como hogares llenos de objetos pequeños.

Asimismo, la compañía ha subrayado que esta base de datos se diferencia por ofrecer interiores 3D de alta calidad y “totalmente creados por humanos”, lo que permite una simulación de alto rendimiento.

PLATAFORMA HOMEROBOT

Finalmente, Meta ha presentado su plataforma de ‘hardware’ y ‘software’ de asistente de robot doméstico HomeRobot, con la que el robot puede aprender y realizar tareas de vocabulario abierto tanto en entornos simulados como en el mundo físico.

Para ello, la plataforma se centra la manipulación móvil de vocabulario abierto (OVMM por sus siglas en inglés). Esto es, la capacidad de recoger cualquier objeto en cualquier entorno invisible y colocarlo en una ubicación específica, lo que requiere una percepción y comprensión alta del espacio.

Con HomeRobot, un robot sería capaz de coger una taza de un armario y colocarla en la mesilla de noche del piso de arriba aunque nunca antes hubiera visto la taza o el dormitorio, según ha ejemplificado Meta.

HomeRobot tiene, por un lado, un componente de simulación, que utiliza un amplio y diverso conjunto de objetos seleccionados en nuevos entornos domésticos de múltiples habitaciones de alta calidad. Por otra parte, dispone de un componente del mundo real, que proporciona ‘software’ para robots como Hello Robot Stretch, con el fin de fomentar la réplica de experimentos entre laboratorios.

Comparte esto:

- Haz clic para compartir en WhatsApp (Se abre en una ventana nueva)

- Haz clic para compartir en Facebook (Se abre en una ventana nueva)

- Haz clic para compartir en Twitter (Se abre en una ventana nueva)

- Haz clic para compartir en LinkedIn (Se abre en una ventana nueva)

- Haz clic para compartir en Telegram (Se abre en una ventana nueva)

Relacionado

You may like

-

La ‘app’ Files de Google contará su propio lector de PDF integrado

-

Gemini 1.5 Pro de Google puede detectar código malicioso en unos 30 segundos

-

Facebook ofrece a creadores de Meta Verified nuevas herramientas para potenciar la visibilidad de sus cuentas

-

ChromeOS 124 llega con mejoras multitarea con la nueva pantalla dividida y la priorización del tráfico WiFi

-

Instagram estrena nuevos ‘stickers’ en Historias, con opciones para compartir música y revelar publicaciones ocultas

-

WhatsApp para Android facilita la liberación de espacio de almacenamiento en Chats y Canales

Tecnología

La ‘app’ Files de Google contará su propio lector de PDF integrado

Published

9 horas agoon

mayo 7, 2024

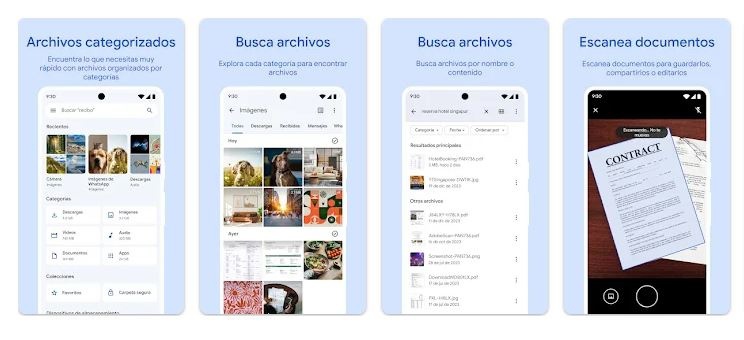

Google está planeando la implementación de un lector y editor de documentos PDF en la aplicación Files (Archivos) de Google para móviles Android, un servicio con el que se dejaría de depender de un tercero para abrir documentos con este formato.

Archivos de Google es una aplicación de administración de archivos desarrollada por la compañía tecnológica que permite explorar documentos, vídeos, imágenes, clips de audio o descargas, entre otros. Se puede descargar a través de Google Play.

Actualmente, esta aplicación depende de un tercero para abrir archivos con formato PDF. De forma predeterminada, Google ofrece Drive PDF Viewer para ello, que viene preinstalado en terminales con sistema operativo Android, tal y como señala Android Police.

Drive PDF Viewer es, por tanto, un servicio de Google que funciona como lector y editor de este tipo de documentos, que introduce herramientas de edición básicas, como un marcador para resaltar texto con un subrayador o un lápiz para realizar anotaciones.

Google estaría trabajando ahora en una herramienta similar independiente para su app de Archivos. Esto significa que, en lugar de depender de este lector de PDF predeterminado, contará con su propio lector de documentos pdf, tal y como ha avanzado recientemente Assemble Debug a través de Telegram.

El investigador ha comentado que este lector dispondrá de dos botones con flechas para moverse por el documento elegido, lo que evitará que el usuario deba hacer ‘scroll’ en la pantalla. Asimismo, introduce un botón de acción flotante (FAB), que alberga diferentes herramientas de edición.

Según Assemble Debug, el lector de PDF ya se está integrando en Files de Google y debería estar disponible próximamente a través de la tienda oficial de aplicaciones de Android, Play Store.

Comparte esto:

- Haz clic para compartir en WhatsApp (Se abre en una ventana nueva)

- Haz clic para compartir en Facebook (Se abre en una ventana nueva)

- Haz clic para compartir en Twitter (Se abre en una ventana nueva)

- Haz clic para compartir en LinkedIn (Se abre en una ventana nueva)

- Haz clic para compartir en Telegram (Se abre en una ventana nueva)

Relacionado

Tecnología

Gemini 1.5 Pro de Google puede detectar código malicioso en unos 30 segundos

Published

19 horas agoon

mayo 6, 2024

La versión más avanzada del modelo de Inteligencia Artificial (IA) que desarrolla Google, Gemini 1.5 Pro, es capaz de analizar y detectar código malicioso en unos 30 segundos, según ha podido comprobar recientemente el equipo de VirusTotal.

La compañía presentó esta última generación de su modelo el pasado mes de febrero, cuando adelantó que introducía una nueva arquitectura con la que era capaz de realizar tareas complejas de forma más ágil y con un rendimineto y un razonamiento mejorados.

Esta versión de su IA funciona con la arquitectura Mixture-of-Experts (MoE), que divide el modelo en pequeñas redes neuronales, que se activan de forma selectiva dependiendo del tipo de información introducida.

Este modelo también puede analizar, clasificar y comprender contextos largos, ya que tiene la capacidad de procesar hasta un millón de tokens. Por ejemplo, una hora de vídeo, once horas de audio, bases de código con más de 30.000 líneas de código o más de 700.000 palabras.

El equipo de VirusTotal, que pertenece a Google, ha comprobado recientemente la capacidad que tiene este modelo de IA para identificar código malicioso, así como para reconocer amenazas de día cero (‘zero day’).

En primer lugar, ha subrayado en un comunicado que el crecimiento “explosivo” de este tipo de ataques “continúa desafiando los métodos de análisis manuales tradicionales, lo que subraya la necesidad urgente de una mejor automatización y enfoques innovadores”.

En este contexto, Gemini 1.5 Pro se ha diseñado para ayudar a los analistas “a gestionar el volumen asimétrico de amenazas de forma

más” para clasificar y agrupar el ‘malware’ en función de patrones de comportamiento y anomalías.

Así lo ha querido demostrar con Code Insight, presentado en la feria de ciberseguridad RSA Conference 2023, una plataforma especializada en analizar fragmentos de código y generar informes en lenguaje natural, emulando el enfoque de un analista de ‘malware’.

Para complementar el trabajo de Code Insight, que tiene una capacidad limitada de entrada de tokens, el equipo de VirusTotal ha trabajado con Gemini 1.5 Pro, que admite hasta un millón de tokens y puede analizar algunos ejecutables descompilados “en una sola pasada”, gracias a lo cual se elimina la necesidad de dividir el código en fragmentos más pequeños.

Este modelo también puede interpretar la intención y el propósito del código y no únicamente identificar patrones. Esto es posible gracias a su entrenamiento con un conjunto de datos de código, que abarca el lenguaje de diferentes arquitecturas.

De esta manera, Gemini puede emular el razonamiento y el juicio de un analista de ‘malware’, predecir sus acciones y proporcionar información sobre las amenazas, incluidas aquellas que no se hayan visto anteriormente (‘zero-day’).

or último, Google ha dicho que la última iteración de su modelo de IA puede generar informes resumidos en un lenguaje legible para humanos, lo que hace que el proceso de análisis “sea más accesible y eficiente”.

Para probar la eficacia de Gemini 1.5 Pro en al detección de código malicioso, VirusTotal lo utilizó para analizar código descompilado con una muestra de ‘malware’ representativa. Así, procesó dos archivos binarios del ‘ransomware’ WannaCry -uno de 268 KB y 231 KB- contenedores de más de 280.000 tokens.

Si bien en sus pruebas con otras herramientas de IA generativas similares tuvo que dividir el código en fragmentos para su estudio, lo que generó “resultados vagos y no específicos”, con Gemini 1.5 Pro, en cambio, no se vio en esa necesidad, ya que fue capaz de procesar todo el código desensamblado o descompilado en una sola pasada y entregar un informe con los resultados en tan solo 34 segundos.

La descompilación del código consiste en construir el código fuente original a partir del binario, lo que puede mejorar su legibilidad y la concisión en comparación del código ensamblado, que pasa por un proceso en el que el código binario se convierte en una representación de nivel bajo de la arquitectura del procesador.

Según Google, este análisis inicial fue “notablemente preciso” y mostró su capacidad para manejar conjuntos de datos grandes y complejos de manera transparente y efectiva”. Asimismo, en este comunicado ha aclarado que no se basa en conocimientos previamente entrenados sobre WannaCry. Esto significa que el análisis surge de la capacidad de Gemini de interpretare código desconocido y malicioso de forma independiente.

Los investigadores también han señalado que Gemini 1.5 Pro demuestra la misma capacidad tanto en el procesamiento de lenguajes de alto nivel como en el ensamblaje de diversas arquitecturas, lo que significa que se puede adaptar el análisis de archivos posiblemente maliciosos según las circunstancias específicas de cada caso.

PRUEBAS CON AMENAZAS DE DÍA CERO

El equipo de investigadores también ha probado la capacidad de Gemini 1.5 Pro para identificar amenazas de día cero que no son detectadas por los métodos tradicionales, como pueden ser el antivirus o el ‘sandbox’ de VirusTotal.

Según sus hallazgos, el modelo de Google pudo procesar un archivo de 833 KB descompilado en 189.080 tokens en tan solo 27 segundos, momento en que produjo un informe completo del análisis del ‘malware’ en una sola pasada.

Además de identificar patrones maliciosos, Gemini 1.5 Pro descifró cuál era el objetivo principal de este ‘malware’, que tenía la intención de robar criptomonedas secuestrando transacciones de Bitcoin y evadiendo su detección al desactivar el ‘software’ de seguridad.

Finalmente, Google ha reconocido que si bien el modelo “desbloquea capacidades impresionantes” al poder analizar grandes volúmenes de código descompilado y desensablado, aún quedan desafíos por abordar “para lograr un análisis de ‘malware’ automatizado verdaderamente sólido y de confianza”. Entre ellos, técnicas de ataque en constante evolución, por lo que los desarrolladores deben “aprender y reconocer nuevas amenazas”.

Comparte esto:

- Haz clic para compartir en WhatsApp (Se abre en una ventana nueva)

- Haz clic para compartir en Facebook (Se abre en una ventana nueva)

- Haz clic para compartir en Twitter (Se abre en una ventana nueva)

- Haz clic para compartir en LinkedIn (Se abre en una ventana nueva)

- Haz clic para compartir en Telegram (Se abre en una ventana nueva)

Relacionado

Tecnología

Facebook ofrece a creadores de Meta Verified nuevas herramientas para potenciar la visibilidad de sus cuentas

Published

1 día agoon

mayo 6, 2024

Meta ha introducido nuevas herramientas en Facebook dirigidas a suscriptores de Meta Verified, con las que busca dar mayor visibilidad y fomentar el descubrimiento de cuentas de creadores de contenido en el apartado de Búsquedas.

Meta Verified es un servicio de pago dirigido a creadores de contenido que la matriz de Facebook e Instagram implementó en España el verano pasado por un precio mensual de 13,99 euros en la web y 16,99 euros en iOS y Android.

Esta suscripción cuenta con una serie de características adicionales, como la insignia azul -que requiere una indetificación previa-, la oportunidad de utilizar ‘stickers’ exclusivos en Stories o Reels y distintas medidas de protección de la cuenta contra la suplantación de identidad.

La compañía ha comenzado a probar dos nuevas características enfocadas a dar mayor visibilidad a las cuentas de los creadores de contenido. Se trata de ‘Optimización de la búsqueda’ y ‘Ayudar en el descubrimiento’, según ha adelantado recientemente Ahmed Ghanem en Threads, respaldado por el analista y consultor Matt Navarra.

Con la primera opción, la plataforma asegura que los suscriptores aparecerán en la parte superior de los resultados de búsqueda, para que los seguidores puedan encontrarles “más fácilmente”.

Con la segunda característica, en cambio, la compañía ofrece a los creadores “disfrutar de más oportunidades para que su contenido y su cuenta sean descubiertos” cuando aparecen como Meta Verified en el ‘feed’ de Facebook.

La firma ha concretado que este “beneficio potencial” se está probando en Meta Verified para añadir “aún más valor” a la experiencia de los suscriptores en la plataforma. Además, ha indicado que se trata de una característica opcional y que, aunque se pueden realizar cambios “en cualquier momento”, estos pueden tardar hasta 24 horas en aplicarse.

Comparte esto:

- Haz clic para compartir en WhatsApp (Se abre en una ventana nueva)

- Haz clic para compartir en Facebook (Se abre en una ventana nueva)

- Haz clic para compartir en Twitter (Se abre en una ventana nueva)

- Haz clic para compartir en LinkedIn (Se abre en una ventana nueva)

- Haz clic para compartir en Telegram (Se abre en una ventana nueva)

Relacionado

Trending

-

Tecnología1 año ago

Tecnología1 año agoXiaomi lanza en España el Redmi Note 12 Pro + 5G desde 499,99 euros con cámara de 200MP y carga rápida de 120W

-

Bolivia4 años ago

ROSITA POCHI, JERARQUÍA Y RITUALIDAD GUARANÍ

-

Tecnología9 meses ago

Tecnología9 meses agoSamsung y Microsoft crean una solución de autenticación en móviles para empresas basada en ‘hardware’

-

Tecnología3 años ago

Huawei reafirma su compromiso con la innovación tecnológica

-

Tecnología1 año ago

Tecnología1 año agoMicrosoft acusa a Sony de dar información falsa a las autoridades de regulación europea sobre la paridad de Call of Duty

-

Internacional2 años ago

Un turista logró captar a un curioso primate en el Parque Nacional Kruger de Sudáfrica

-

Música1 año ago

Música1 año agoYouTube Music agrega un temporizador de suspensión para configurar cuándo dejar de reproducir contenido automáticamente

-

Empresa1 año ago

Empresa1 año agoINTI confía en las mujeres: representan un 50% de su liderazgo y son pilar de las acciones de RSE

You must be logged in to post a comment Login