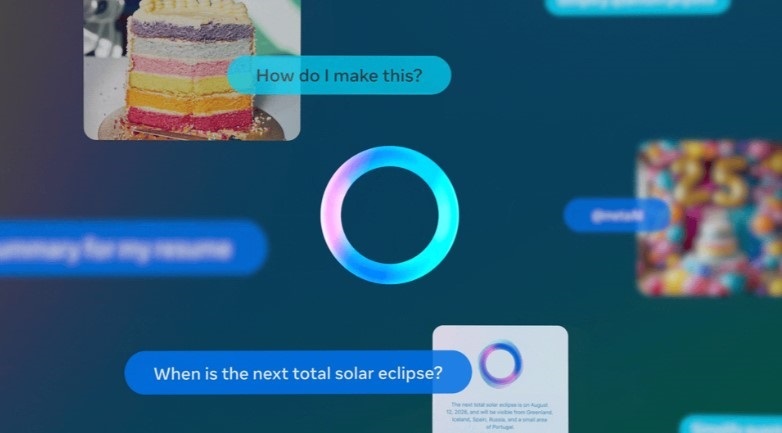

OpenAI continúa trabajando para hacer de su ‘chatbot’ impulsado por inteligencia artificial (IA) ChatGPT un «superasistente», que sea capaz de conocer al usuario, entender lo que le importa y ayudar con cualquier tarea de forma «emocionalmente inteligente», de la mano de sus modelos o3 y sus capacidades de razonamiento multimodales.

Actualmente, los usuarios utilizan ChatGPT principalmente para resolver sus preguntas, generar contenido y codificar, entre otras opciones pensadas para aliviar las cargas de trabajo en su día a día. Sin embargo, la compañía liderada por Sam Altman pretende extender su uso más allá, convirtiendo el ‘chatbot’ en «un experto, un consejero, un colaborador o un compañero y analizador» personalizado para los usuarios.

Como ya ha comentado la tecnológica en anteriores ocasiones desde que lanzó su ‘chatbot’ al mercado, la idea es ir avanzando con su producto de IA agregando nuevas tecnologías y capacidades que lo conviertan en lo que denomina como un «superasistente».

En este marco, OpenAI ha confirmado en un documento interno titulado ‘ChatGPT: H1 2025 Strategy’, que data de finales de 2024 y al que ha tenido acceso ahora The Verge, que estos planes para convertir ChatGPT en un superasistente comenzaron en la primera mitad de este año, con el objetivo de ofrecer un producto que conozca al usuario, entienda sus intereses y ayude a mejorar su vida en cualquier aspecto.

Concretamente, la compañía describe a ChatGPT como un superasistente que entiende lo que le importa al usuario y «ayuda en cualquier tarea que pueda hacer una persona emocionalmente inteligente y confiable con un ordenador».

Según los planes de la compañía, se trata de un momento oportuno dado que modelos como o3 «son por fin lo bastante inteligentes para realizar tareas de forma fiable», además de poder utilizar herramientas como el ordenador, que «pueden potenciar las capacidades de actuación de ChatGPT».

Igualmente, OpenAI ha mencionado que disponen de paradigmas de interacción, como la multimodalidad y la interfaz de usuario generativa, que permiten tanto a ChatGPT como a los usuarios «expresarse de la mejor forma posible para cada tarea».

Con todo ello, la compañía también ha definido su idea de superasistente, como «una entidad inteligente con habilidades en forma de ‘T'», esto es, que cuenta con amplias competencias para tareas cotidianas que resultan tediosas y tareas que requieren amplios conocimientos, como la codificación.

De esta manera, se trata de una entidad que actúa de personalizada y que está disponible desde cualquier plataforma, ya sea mediante la web como a través de aplicaciones nativas, ‘smartphones’ o plataformas de terceros como Siri de Apple.

Igualmente, podrá llevar a cabo todo tipo de acciones, desde encontrar una casa, hasta ponerse en contacto con un abogado, planificar vacaciones, gestionar calendarios o enviar correos electrónicos.

ENFRENTAMIENTO CON NAVEGADORES

Por otra parte, OpenAI ha calificado como competidores a las principales empresas en el sector de ‘chatbots’ para el consumidor, como es el caso de Claude de Anrhropic, Gemini de Google, Copilot de Microsoft y Meta AI de Meta. Al respecto, ha sentenciado que aunque son «líderes» del sector, «no pueden descansar».

Para ello, OpenAI busca ofrecer el mejor modelo gratuito, la mejor interfaz de usuario y la marca «más fuerte». Además, también ha subrayado que, al generar un superasistente, se enfrentan a motores de búsqueda, navegadores e incluso, a las interacciones con personas reales.

«Se trata de resolver cada vez más casos de uso e ir atrayendo poco a poco a los usuarios. Por eso no llamamos a nuestro producto motor de búsqueda, navegador o sistema operativo, sino ChatGPT», ha sentenciado.

Con todo, OpenAI ha reflejado que están en el momento óptimo y disponen de lo necesario para avanzar hacia un «superasistente», al contar con «uno de los productos de más rápido crecimiento», un «líder» en investigación tanto a nivel de razonamiento como de capacidades multimodales y de computación, y un equipo de investigación «de primera clase».

TecnologíaHace 2 años

TecnologíaHace 2 años

EconomíaHace 2 años

EconomíaHace 2 años

EconomíaHace 1 año

EconomíaHace 1 año

EconomíaHace 2 años

EconomíaHace 2 años

BoliviaHace 3 años

BoliviaHace 3 años

EconomíaHace 1 año

EconomíaHace 1 año